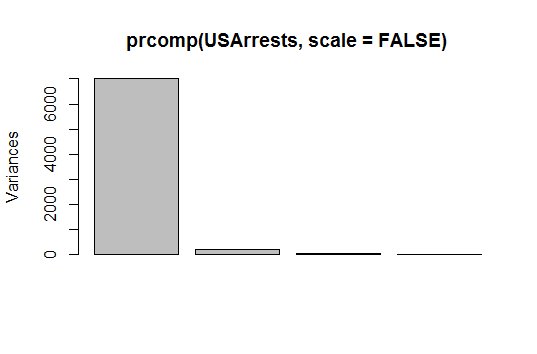

Normalisierung ist bei PCA wichtig, da es sich um eine Varianzmaximierungsübung handelt. Es projiziert Ihre Originaldaten auf Richtungen, die die Varianz maximieren. Das erste Diagramm unten zeigt den Betrag der Gesamtvarianz, der in den verschiedenen Hauptkomponenten erläutert wurde, in denen wir die Daten nicht normalisiert haben. Wie Sie sehen können, scheint wie wie Komponente 1 den größten Teil der Varianz in den Daten zu erklären.

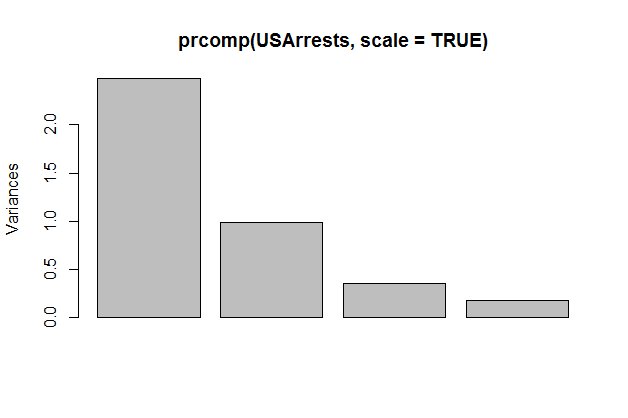

Wenn Sie sich das zweite Bild ansehen, haben wir zuerst die Daten normalisiert. Hier ist klar, dass auch die anderen Komponenten dazu beitragen. Der Grund dafür ist, dass PCA versucht, die Varianz jeder Komponente zu maximieren. Und da die Kovarianzmatrix dieses bestimmten Datensatzes lautet:

Murder Assault UrbanPop RapeMurder 18.970465 291.0624 4.386204 22.99141Assault 291.062367 6945.1657 312.275102 519.26906UrbanPop 4.386204 312.2271 pre> Aus dieser Struktur wählt die PCA aus, so viel wie möglich in Richtung Assault zu projizieren, da diese Varianz viel größer ist. Um also Funktionen zu finden, die für jede Art von Modell verwendet werden können, würde eine PCA ohne Normalisierung schlechter abschneiden als eine mit Normalisierung.